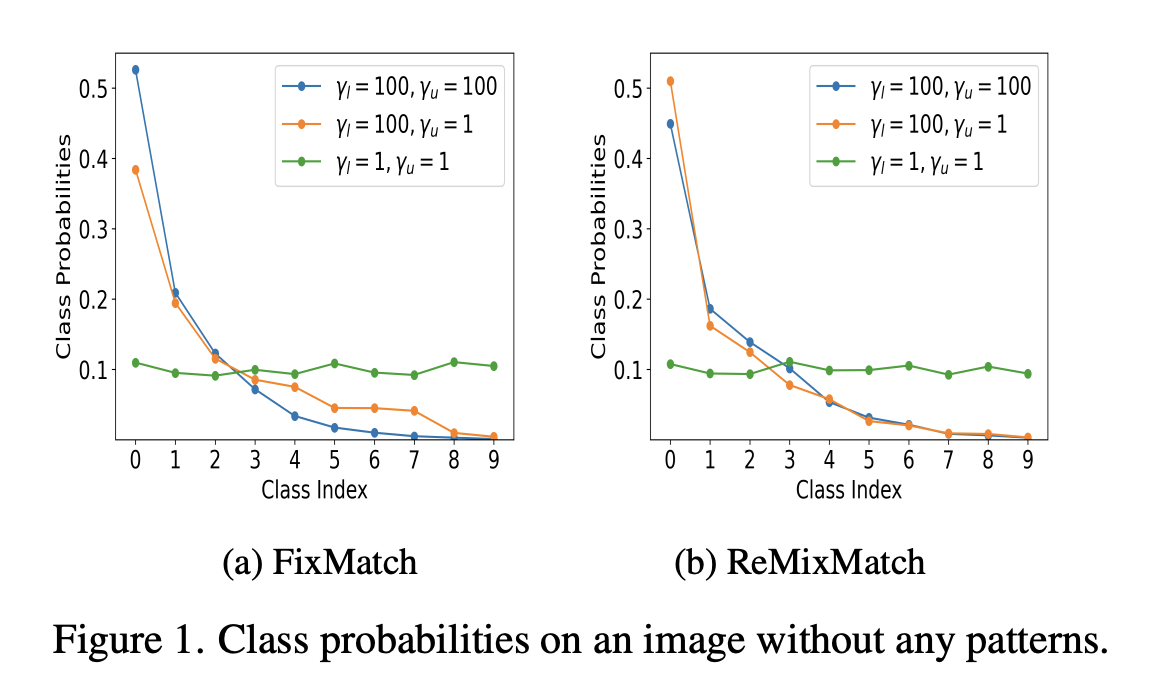

이 논문은 NeurIPS 2020에 출판되었으며, 저자는 Kihyuk Shon*, David Berthelot*, Chun-Liang Li, Zizhao Zhang, Nicholas Carlini, Ekin D. Cubuk, Alex Kurakin, Han Zhang, Colin Raffel로 구성되어 있다. Motivation Deep neural network는 큰 데이터셋을 활용할 수록 더 높은 성능을 달성할 수 있다는 것이 잘 알려져 있지만, data를 labeling하는 것의 cost가 굉장히 비싸기 때문에 큰 labeled 데이터셋을 만들기가 어렵다는 문제가 있다. 따라서 소수의 labeled data와 많은 양의 unlabeled data를 활용하여 학습을 진행하는 semi-supervise..