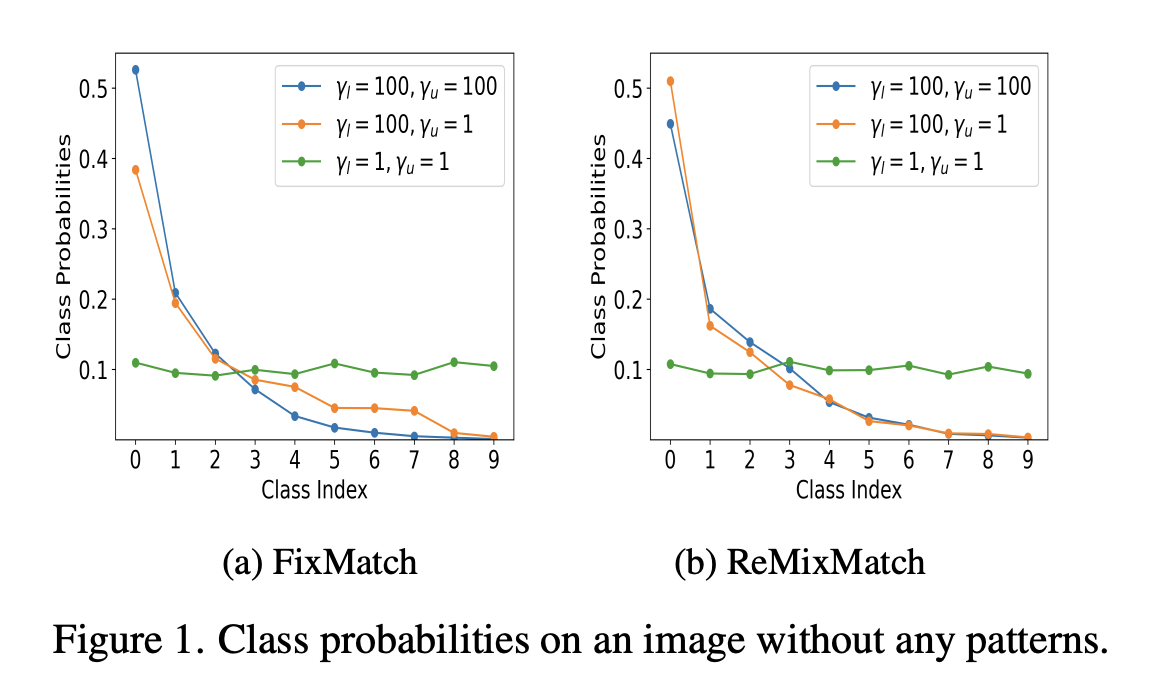

이 논문은 CVPR 2024에 출판되었으며, 저자는 Hyuck Lee, Heeyoung Kim으로 구성되어 있다. Motivation Pseudo-label 기반의 semi-supervised learning (SSL) 알고리즘을 class-imbalance 세팅에서 사용하는 경우 다음의 두 가지 문제가 발생한다. 1. Classifier가 majority class에 편향되는 경향이 있다. 2. 편향된 classifier로부터 생성된 pseudo-label들이 training에 사용된다. 이 문제를 해결하기 위해서는 classifier를 적절히 re-balance하는 것이 필요하다. 하지만 unlabeled set의 class distribution은 (2) 알 수 없는 경우가 많으며 (2) label..